An Explainable Deep Learning Framework for Resilient Intrusion Detection in IoT-Enabled Transportation Networks -- 2023

安全性对于像车联网(IoV)这样的安全关键物联网系统来说至关重要,这些系统通常关注于使用入侵检测系统(IDS)来识别物联网网络中的网络攻击。由于它们能够从异构数据中学习,深度学习方法通常被用于许多IDS的异常检测引擎。然而,这种类型的机器学习模型会产生高误报率,而且其预测的原因即使对专家来说也不是很容易理解。能够理解或掌握IDS阻止特定数据包决策背后的推理,有助于网络安全专家验证系统的有效性,并开发出更具网络弹性的系统。本文提出了一种基于可解释深度学习的入侵检测框架,有助于提高物联网网络中基于DL的IDS的透明度和弹性。该框架采用了一种称为SHapley Additive exPlanations(SHAP)的方法来解释深度学习基础的IDS做出的决策,以便专家能够依赖这些决策来确保物联网网络的安全,并设计出更具网络弹性的系统。该框架使用ToN_IoT数据集进行了验证,并与其他一些有吸引力的技术进行了比较。实验结果表明,该框架具有很高的性能,准确率为99.15%,F1得分为98.83%,这证明了其保护IoV网络免受复杂网络攻击的能力。

引言

- 随着物联网设备的广泛使用,人们开始重视隐私和网络安全的问题。

- 由于物联网设备的全球访问性和资源受限的性质,传统的防火墙和入侵检测不再适用。

- 近些年基于深度学习的入侵检测效果显著,但是其不可解释性成为领域专家谨慎考虑这种解决方案的原因之一。

- 该文章的主要工作是提出一种可以解释的基于人工智能的IDS框架,并首次将此前应用于自然语言模型的SHAP方法应用到网络入侵检测领域。

前人工作

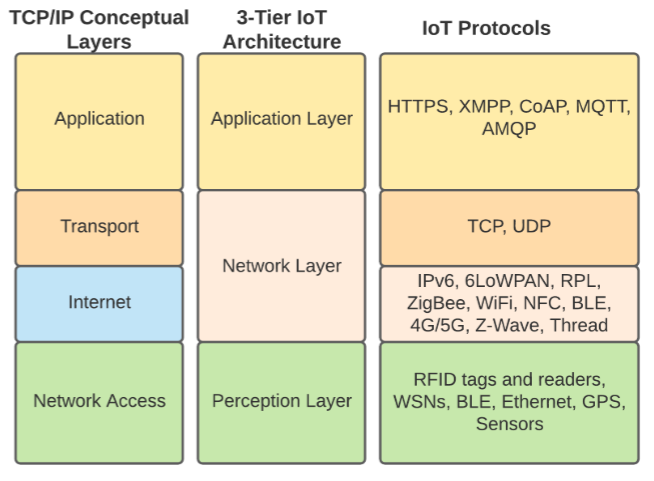

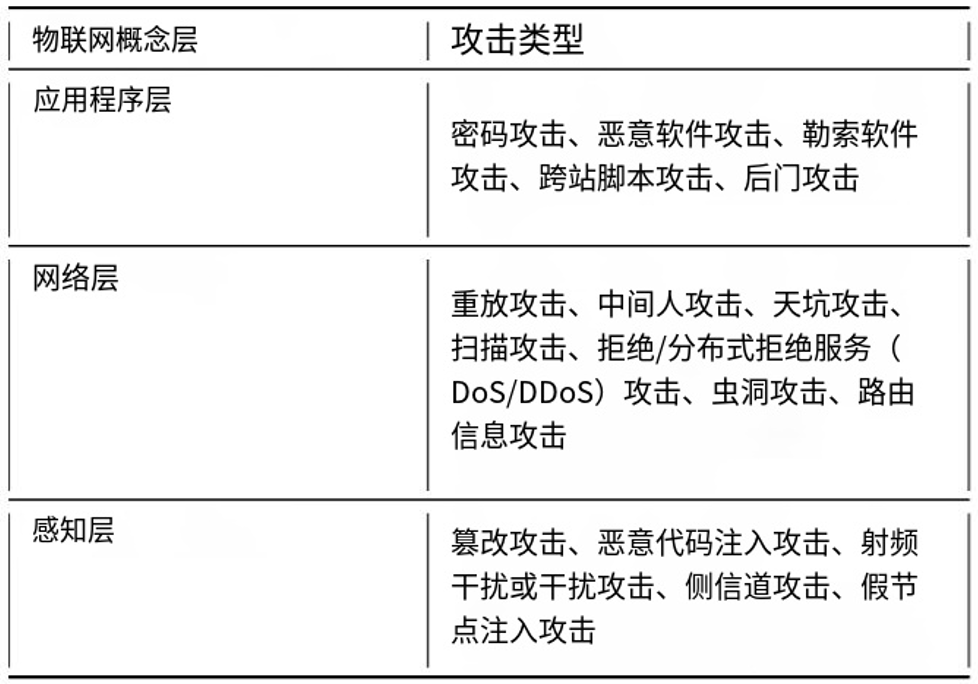

物联网架构、协议和面临的威胁

- 体系架构

- 各层面临的威胁

- 虽然对物联网系统的各种攻击可能发生在物联网架构的任何一层,但大多数攻击都是针对网络层。现在的防御策略主要是使用入侵检测系统来检测和防御对物联网的网络攻击

介绍IDS

- 在物联网架构中,IDS再网络层内运行。

- IDS通常的两种检测方法:

- 基于特征的检测:如基于签名的IDS,对于低误报率的已知攻击有效,不检测零日攻击

- 基于异常的检测:将正常网络流量基线化,然后将任何偏差标记为异常,对零日攻击和已知攻击都有效,但是通常有很高的假阳率

- 混合IDS:基于特征和基于异常混合的检测,从而达到相对较低的假阳率检测已知和零日攻击

- 但是现在不断出现新技术从而绕过传统的入侵防御系统,所以近年来开始研究使用机器学习和深度学习技术来检测安全威胁。如采用分布式深度学习,通过工作节点和主节点之间的参数和模型交换来检测对物联网/雾网络的攻击。

可解释的人工智能

- 可解释AI以人类用户呢能够理解的系统化和方式提供其有关行为的解释

- 许多文章中将‘interpretability’ and ‘explainability’ 交替使用,但二者含义不同,浅层机器学习模型通常具有较高的可解释性(Interpretability),而更复杂的深度学习模型通常需要借助可解释性(Explainability)的方法来解释其预测结果

- Interpretability:模型自身是否易于理解。

- Explainability:通过外部工具解释复杂模型的决策。

- 对人工智能的解释方法

- 文本解释(Text Explanations):通过提供文本数据来解释模型预测的依据,帮助用户理解模型决策背后的逻辑。

- 特征相关性解释(Feature Relevance Explanations):通过计算模型管理变量的相关性分数,解释模型复杂的内部函数,揭示哪些特征对模型的决策影响更大。

- 局部解释(Local Explanations):通过测量模型对局部变化的响应来构建解释,重点关注模型在特定输入附近的决策过程。

- 基于代表性样本的解释(Explanations using representative examples):通过提供训练数据集中的代表性样本,帮助用户更好地理解数据如何影响模型的决策。

- 基于代理函数的解释(Explanations using surrogate functions):通过创建一个简化模型(代理模型)来替代原始复杂模型的内部函数。简化后的模型更透明、更易于解释,同时保持与原始“黑箱”模型相似的性能。

- 可视化解释(Visual Explanations):通过可视化技术展示模型的行为,常用于图像分类任务,生成解释图像被归为特定类别的原因。

- 这篇论文使用SHAP框架来解释物联网网络中基于DL的入侵检测系统的预测

SHAP解释算法

- SHAP是一种特征相关性解释框架,通过计算每个特征对最终预测结果的贡献,SHAP可以量化各个特征的重要性,并提供一致且公平的解释。SHAP通过识别一类可加性特征归因方法,然后根据三个理想的属性,即局部准确性、缺失性和一致性,显示该类中存在唯一解,从而提供可解释性。

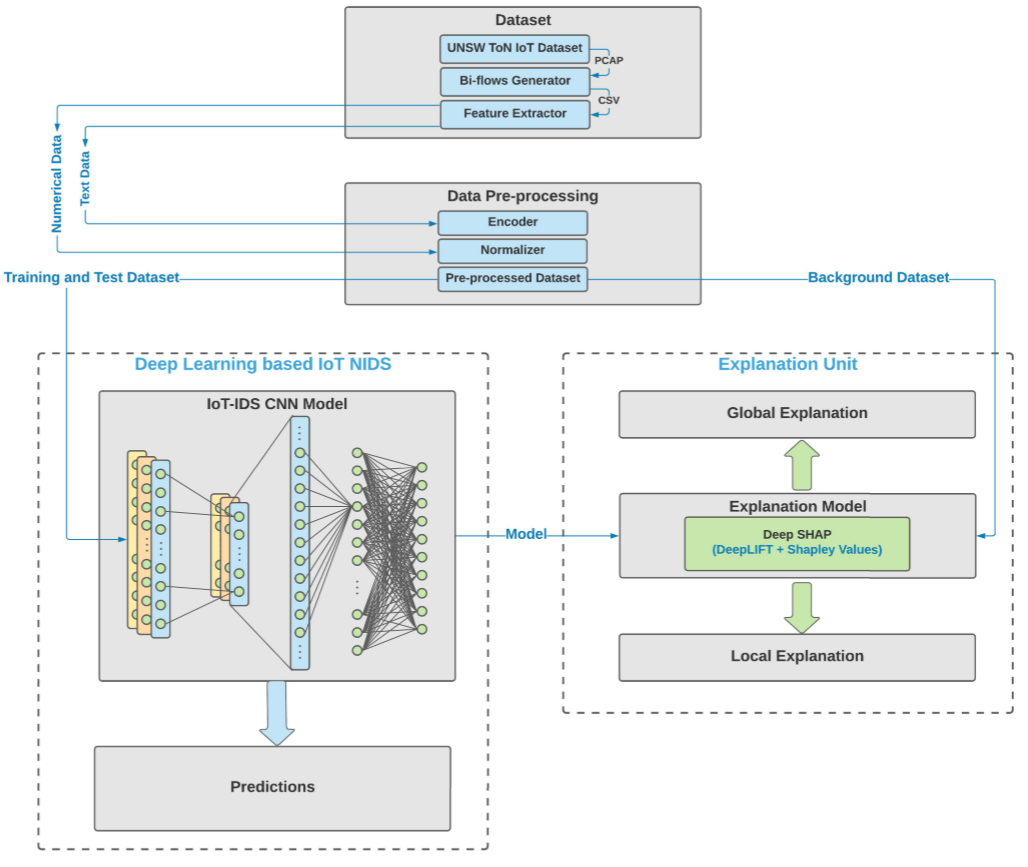

框架设计

- 基于CNN深度学习模型的IDS:接收从IoV网络流量中提取的特征,经过CNN网络和softmax激活函数输出网络流量是攻击流量的概率

- 基于Deep SHAP算法的解释单元,主要包含两个功能:

- 局部解释:用于解释单个预测结果,展示哪些特征对模型的预测产生了最大影响。使用SHAP的Force Plot可视化每个特征对预测的影响。例如,对于一个被预测为扫描攻击的流量,解释单元可以显示“每秒流量字节数”这一特征对预测的正向影响最大。

- 全局解释:用于提供模型整体行为的解释,展示哪些特征对模型的预测最为关键。SHAP Summary Plot展示所有特征的重要性排名及其对预测的正负影响;SHAP Dependence Plot展示特定特征值的变化对预测结果的影响。

实验

- 数据集:使用ToN_IoT数据集,实验中采用数据包捕获的原始数据格式,即PCAP。其中包含现实世界物联网和工业物联网的实际特征,拥有正常的流量和纠正不同模拟攻击流量,包括:注入,中间人(MITM),后门,分布式拒绝服务(DDoS),拒绝服务(DoS),勒索软件,扫描,跨站点脚本(XSS)和密码攻击。

- 然后使用CICFlowMeter工具从ToN_IoT PCAP文件中生成双向网络流,并从中提取基于流的特征。

- 数据预处理:在实验中,作者发现数据包五元组特征要么高度相关,要么对模型输出贡献很小,因此作者将这些特征从数据集中删除。然后将数据集中唯一非数字特征的“label”进行二进制编码,并且为了便于训练,作者还将与时间有关的特征归一化到[0,1]范围内。

- 结果:基于CNN的IDS具有很好的准确率、召回率、F1分数。并且根据ROC曲线得到本文的模型在预测扫描和密码攻击方面表现良好

- 模型解释:使用SHAP算法开发者提供的python SHAP包绘制不同的可视化图,从而进行局部和全局解释。

作者总结

- SHAP的缺点是计算量大,运行成本高,容易受到对抗性攻击