When LLMs meet cybersecurity: a systematic literature review -- 2025

大语言模型(LLM)的快速发展为包括网络安全在内的各个领域开辟了新的途径,网络安全面临着不断变化的威胁格局和对创新技术的需求。尽管对LLM在网络安全中的应用进行了初步探索,但缺乏对这一研究领域的全面概述。本文通过提供系统的文献综述来解决这一差距,涵盖了对300多部作品的分析,包括25个LLM和10多个下游场景。我们的全面概述解决了三个关键的研究问题:cybersecurity-orientedLLM的构建,LLM在各种网络安全任务中的应用,挑战以及该领域的进一步研究。 本研究旨在阐明LLM在加强网络安全实践方面的广泛潜力,并作为在该领域应用LLM的宝贵资源。我们还在https://github.com/tmylla/Awesome-LLM4Cybersecurity上维护并定期更新网络安全LLM实用指南列表。

引言

-

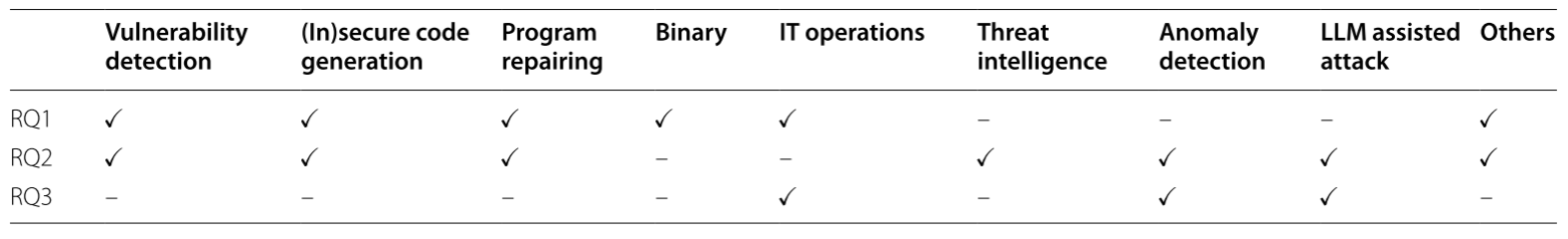

该文章研究LLM适用的各种网络安全任务和应用,包括漏洞检测、

安全代码生成、程序修复、二进制、信息技术操作、威胁情报、异常检测和LLM辅助攻击 -

文章调查了LLM在网络安全领域自2023年以来的300多篇相关论文。

-

网络安全中使用的LLM:开源模型如Llama和Mixtral,可以针对特定网络安全任务对其微调,但是开源模型的性能和规模不如闭源模型。闭源模型如ChatGPT和Gemini,性能出色,但是缺乏透明度引起人们对其在网络安全应用的担忧。此外,基于代码的LLM比基于自然语言的模型更适用于网络安全领域中包括代码生成、代码审计任务,如StarCoder。

-

LLM可以应用于的网络安全任务类别:威胁情报、漏洞检测、恶意软件检测和异常检测、模糊和程序修复、LLM辅助攻击以及安全代码生成等。

如何构建网络安全领域LLM

从零开始训练网络安全LLM一般的做法为选择通用的LLM作为基础模型,然后对其进行微调

选择基础模型

-

基本思想是选择具有强大网络安全能力的LLM或在特定安全任务中表现出色的LLM。现有的LLM网络安全能力评估(即数据集类型)可以分为几类:

网络安全知识、安全代码生成、IT运营、Capture-the-Flag(CTF)和网络智能。 -

网络安全知识评估方法侧重于评估模型对网络安全概念的理解,属于对文本的推理理解。安全代码生成测试模型生成代码的能力,可用于筛选执行代码审计和生成任务的基础模型。IT运营能力用于评估模型在管理和保护IT基础设施方面的熟练程度,包括对安全情况的认识、安全威胁分析和事件响应,也是属于对文本的推理理解。NYU CTF数据集用于评估LLM解决网络安全中捕获关键信息的能力,旨在提高LLM在交互式网络安全任务和自动化任务规划中的效率。

-

本节并没有提到网络流量相关的数据集,多是关于纯文本的数据集。

构建网络安全LLM关键技术

-

为了将一般LLM应用于网络安全,主要采用两种方法:持续预训练(CPT)和监督微调(SFT)。

-

持续预训练指使用大量未标记的特定数据对预训练的LLM进行进一步训练。

-

监督微调使用标记的特定数据集进行训练。目的是提到特定任务的性能。

-

-

微调模型时可选择全参数微调(FULL)和参数高效微调(PEFT)

- FULL:在训练期间调准模型的所有参数,可以实现特定任务或数据集的最佳性能,但效率和可扩展性差

- PEFT:仅微调少量模型参数或附加参数,同时冻结预训练LLM的大多数参数,这大大降低了计算成本

网络安全领域微调LLM

- 使用合适的数据集对LLM进行特定任务的微调

- 机器语言模型(MLM)能够解决普通LLM在理解机器语言上的局限性。TrafficFormer是一种针对流量数据设计的高效预训练模型,针对流量数据的特点,在预训练阶段引入细粒度多分类任务,增强流量数据的表征性;在微调阶段,利用随机初始化特征,提出一种流量数据增强方法,帮助流量模型关注关键信息。这样可以提高模型流量检测和协议理解的准确性。

LLM在网络安全中的潜在应用

调查了现有LLM在威胁情报、漏洞检测、程序修复等任务的使用情况。

威胁情报分析

- 该领域的LLM主要工作是从大量文本中提取有价值的信息,但是训练数据来源可能比较困难,大多数威胁情报提供者所提供的数据并不规范,此外,该领域的LLM模型效果尚不及人类专家,但是可以作为辅助工具,提取的重要信息以帮助人类分析师。

漏洞检测

- 该文中模糊了“漏洞”和“软件缺陷”的概念。

- 有研究评估GPT-3/3.5识别java代码中一些已知的CWE漏洞效果不佳,但经过微调后效果比静态分析和基于深度学习工具效果更好。许多研究都表明LLM在漏洞检测方面具有巨大应用潜力

- 训练LLM用于检测软件漏洞一般不会直接将代码作为输入,而是对其做一些预处理或与其他信息一同输入

- 有研究允许LLM请求关于目标代码的额外上下文信息。此外,他们得出结论,输入到LLM的信息并不是越多越好。完整的漏洞报告等过多的信息,以及大量的调用上下文,可能会导致分心。

- GPTLENS是胡等人创新的两阶段框架,其中包括两个对抗性代理角色:审核员(auditor)和批评家(critic)。auditor在生成阶段执行,其主要目标是识别代码中的潜在漏洞。critic在识别阶段工作,其主要目标是评估审核员识别的漏洞是否真实存在以及严重性。该框架能够减少误报和漏报。

异常检测

- 基于日志的异常检测

- 有研究测试了60种针对日志分析进行微调的语言模型,包括BERT、RoBERTa、DistilRoBERTa、GPT-2和GPT-Neo等不同架构的模型,结果表明这些微调模型可以有效地用于日志分析。

- LogGPT是一个日志异常检测框架,该框架由三个主要组件组成:日志预处理、提示构造和响应解析器。日志预处理组件将原始日志消息过滤、解析并分组为结构化格式以供进一步分析。响应解析器提取ChatGPT返回的输出,用于对检测到的异常进行详细分析和评估。

- web内容安全

- LLM可用于钓鱼邮件和垃圾邮件检测。本笔记重点关注LLM在恶意URL、网络攻击检测方面的内容。

- 有研究使用知识蒸馏方法检测恶意URL,知识蒸馏是一种模型压缩技术,旨在将大型复杂模型(教师模型)的知识迁移到小型简单模型(学生模型)中,以提高学生模型的性能,同时保持模型的轻量化。这个研究利用教师模型对未标记的数据进行预测,生成软标签,然后将这些带有软标签的数据所谓学生模型的输入进行训练,从而让学生模型在保持较高准确率的同时,具有更少的参数和更低的计算复杂度。

- 隐私保护固定长度编码(PPFLE)是一种对流量的新型编码方法,然后,他们用这些编码数据训练一个名为SecurityBERT的模型,对流量执行分类任务,该研究通过隐私保护编码技术,确保数据安全,同时利用BERT架构的高效性

- 有研究提出了名为HuntGPT的系统,该系统将LLMs与传统机器学习方法结合,用于异常检测。使用KDD99数据集训练随机森林分类器以识别网络威胁。为了增强可解释性,系统结合了SHAP(SHapley Additive exPlanations)和LIME(Local Interpretable Model-agnostic Explanations)等XAI(可解释人工智能)技术

这篇论文就看到这里吧,30多页的内容非常详尽,主要都是在讲应用于网络安全的大语言模型,比如用于总结网络安全概念和知识的语言模型、对威胁情报提取信息的模型,当然也有代码漏洞分析和异常检测的模型的综述。我本来是想找找讲利用大语言模型中某些技术细节,将其应用到网络安全领域特别是异常流量检测方面的综述。感觉好像找错了方向🤔这篇论文就先看到这吧